摘要: 刚在上星期开了发布会零一天地万物创办人李开复,相隔不到一周再一次通过线上亲身和一小部分新闻媒体沟通交流,并且在沟通会的开端则表示“掩不住激动,希望直接开新品发布会跟大家分享这一消息。” 这一让李开复无……

刚在上星期开了发布会零一天地万物创办人李开复,相隔不到一周再一次通过线上亲身和一小部分新闻媒体沟通交流,并且在沟通会的开端则表示“掩不住激动,希望直接开新品发布会跟大家分享这一消息。”

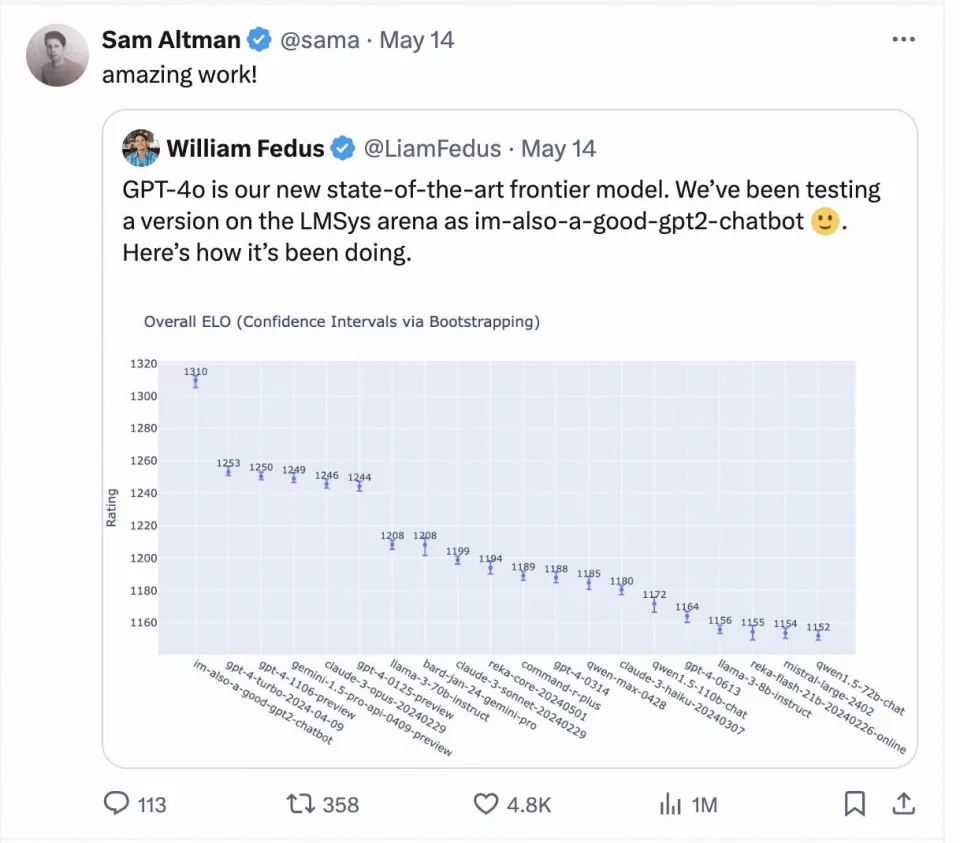

这一让李开复无比激动消息便是,零一天地万物递交的“Yi-Large” 千亿元主要参数闭源大模型在LMSYS Org公布的Chatbot

Arena获得了榜单排名第七的名次。

过去一年的实体模型水平之战中,每一次新模型公布,实体模型水平Benchmark得分便会做为标准动作被同时公布,来实测模型各种各样综合素养。可是,到底怎么样讲解这种得分?什么才是有公信力的实测标准集,业内并没有统一的标准。

但在Gpt-4o公布后,OpenAI CEO Sam Altman亲身转帖引入 LMSYS arena

盲测争霸赛的检测结果。

为何Sam Altman会引入LMSYS 得到的结果?为啥这个榜单取得成就会使李开复激动不已?

LMSYS Org公布的Chatbot

Arena,词是盲测和开放。用通俗的语言来表示便是,它方式是由众包平台的形式对大数据进行密名实测,用户可官方网站键入难题,再由一个或者多个客户并不了解知名品牌大实体模型与此同时返回结果,客户根据自身的期待对实际效果进行投票。

在收集真实用户网络投票数据之后,LMSYS Chatbot

Arena还使用Elo评分标准来量化模型表现,进一步优化评分体系,务求公平公正反映参加者整体实力。然后用Elo评分标准来得到综合评分。简单地来说,在Elo评分标准中,每一个参加者都会获得标准得分。每轮比赛后,参加者评分会基于赛果作出调整。系统会根据参加者得分来计算其赢得胜利的几率,一旦分太低参赛选手战胜高分数参赛选手,那样分太低参赛选手就能获得比较多的成绩,反之偏少。

实测页面

在国外大型厂管理层中,不仅仅Sam Altman,Google DeepMind首席科学家Jeff Dean也曾经引入LMSYS

Chatbot

Arena排名数据信息,来佐证Bard产品的性能。OpenAI、Google等本身的旗舰实体模型公布后第一时间递交给LMSYS,自身的确显示出了国外头顶部大型厂针对Chatbot

Arena的巨大重视。

纽约时间2024年5月20日刚触发的 LMSYS Chatboat Arena 盲测结论,来源于迄今积淀超出

1170万全球用户真正得票数:本次Chatbot

Arena一共有44款实体模型比赛,既包含了顶级开源系统实体模型Llama3-70B,也包含了每家大公司的闭源实体模型。

在这个榜单上,我们也看到了我国大模型身影,智谱GLM4、阿里巴巴Qwen Max、Qwen

1.5、零一天地万物Yi-Large、Yi-34B-chat 本次都是有参加盲测,零一天地万物递交的“Yi-Large”

千亿元主要参数闭源大模型榜单排名第七,在榜单外,LMSYS

的表达类型上增加了英文、汉语、法语三种语言实测,开始重视全世界大模型的多样化。Yi-Large的中文语言分榜上技压群雄,与 OpenAI

官方宣布才一周的史上最强 GPT4o 并列第一,Qwen-Max 和 GLM-4 在中文榜上都体现非凡。

“我国大模型与OpenAI旗舰级模型差别逐渐从7-10年缩减到了6个月。”李开复在线上沟通大会上高兴地表述。与此同时,他就号召“无论是出于本身实体模型水平迭代的考虑到,或是着眼于长期性知名度的角度,大模型生产商理应全身心投入到像Chatbot

Arena这种权威性实测平台上,通过实际的用户满意度和专业实测体制来确认其产品的竞争力。这不但有利于提升生产商自身的品牌形象市场占有率,也有助于推动全部行业的发展,推动技术创新和产品升级。”

与此同时,李开复也十分直接的批判了“做秀式实测方法”,他强调“反过来,这些挑选做秀式实测方法,忽略真正运用效果的厂商,实体模型水平与市场需求之间的鸿沟会越发明显,最后将无法市场竞争中立足于。”

在简短媒体交流会上,李开复也真诚回应了新闻媒体有关实体模型实测的普遍性、实体模型成本降低、全世界大模型市场竞争差别等诸多问题,以下是一部分访谈问题纪实:

Q:Yi-Large的确在我国大模型排名第一,但是我觉得前面还有海外大型厂实体模型,您觉得导致这个差距的原因主要是哪些,是人才吗?怎样追逐?

李开复:感谢,我认为最先我们不能明确自己是我国第一,所以中国只有三个实体模型参与,也希望之后可以更明确的验证这一点。

可我并不是特别觉得我们和全世界存在差距,当然你要用他们最好的对咱们最好的就是有一定的差距,但与此同时很有可能需要考虑她们例如Google组织是2000人,OpenAI是1000人,在我们这里把实体模型加infrastructure加在一起也不到100人,并且我们要用GPU算率做这种练习不上他的1/10,我们自己的实体模型规格也不到它的1/10。

换一个角度而言,如果要评定千亿元实体模型,起码在这一榜单上是世界第一,这些点大家还是无比自豪,在一年前大家落伍OpenAI跟Google

开始做起大模型产品研发的时间节点有7到10年,如今我们跟着她们差距在6个月上下,这一大大的降低。

这6个月如何来?可以回到LMSYS

6个月之前的榜,或是今日比我排行在之前的几个,大部分都是在今年的发出的实体模型,上年模型仍在排行榜上,己经击败了。

另外一个角度观察,现在我们公布的该模型在5月的时候也可以击败上年11月以前的一切实体模型,所以我认为还可以科学合理的推理出大家落伍6个月。

6个月的差异我觉得不是非常大,我认为是一个令人惊奇的非常速度赶追,这几个方面我也非常自豪。

如果你说美国人才是否有独特的地方?肯定是有,从自己写的《AI·未来

》这书以后,我一直都坚持不懈美国是做开创性科学研究,想像力非常强的一批专家,在这一方面在世界上是无对手的。

可是在同一这书里我也说了,中国人聪慧、努力、勤奋是不容忽视的,大家把那7-10年降到仅有6个月,就证明了做好一个实体模型绝对不会仅仅看着你大多能写毕业论文,大多能创造发明新的事物,先弄或后再做,做的最好的才是很强的,Google检索比雅虎网晚多做一些,但是完全没法比。

所以我认为之后有后发的优点,但是同时我们特别尊重国外这种创造力,他的毕业论文希望她们再写,我们都是每一篇都是会认真阅读,大家和他们有许多改进的地方。但是比起执行能力,比作出一个很好的感受,做比商品,比商业运营模式,我觉得大家强过美企。

Q:现在大多数排行榜,比如零一天地万物提及的斯坦福大学的Alpaca Eval,如今又有很大实体模型试炼场,什么实测会比较客观呢?

李开复:我觉得这个两个人都是公正公平的,Alpaca

Eval是斯坦福学校用GPT4实测的,今日的LMSYS是真几万元本人评定一个实体模型,严苛叫我挑哪一个更可靠得话,虽然我们在Alpaca排行更高一些,但我觉得LMSYS是更加可靠的。

黄文灏:许多benchmark,包括我们之前大家要比MMLU、GSM8K这种,以前benchmark的物理题万变不离其中,是有一个确立的实测集,当题型已经彻底确定以后,大伙儿可以在上面对于题型做一些生成数据信息,使模型在某一些层面水平变得更高。

而LMSYS生活中有几个方面比较合适,一方面就是它的题真实用户闲聊之中给出的题,因此这个题是动态变化的,没有人能够预测分析题型遍布是什么样的,就没办法对于题型遍布去模型拟合做单一层面的改善,所以它是overall模型水平的反映。

第二,由于标题是动态随机,而且它的普遍性很有可能更加高一些。

第三,是由用户来进行打分得到的结果,应用GPT-4评分,会有点模型喜好性。客户的评分与用户是更加亲近的,因此这个榜单也会跟实践应用之中客户的preference更贴近,这和我们制成模因一体的理念是相符的。

Q:有业内人士曾经说过全部的统计检验都不对,您怎么看?如今大模型公布给出的专业测评比照有什么使用价值吗?第二个问题较为,零一天地万物接下来会发布更高参数实体模型吗?现在一些公司开始做起小模型,您觉得如今卷主要参数还有什么意义?

黄文灏:先解答第一个问题,以前的benchmark确实有一些试题的变化规律性不足,因此会出现有些人讲的,例如定项优化分析某种水平,我觉得不是积分墙,而是将实体模型一些功能做提高。这种提高在单一能力方面有意义,但是非常的时候我们不知道他们实体模型提高了这些方面水平,那一个实体模型提高那方面的优势,因此大家在相对比较情况下不一定会公正公平,而LMSYS是提供一个比较好的更贴近客户真实情景的一种实测方法,它方法也是由于题型动态性偶然性不适宜大伙儿做优化,因此可以当作一个比较好的规范来衡量模型水平。

第二个问题我就先简单说一下,由开复教师主要讲的是。我认为做更多的实体模型就是我们会一直追求,只要我们企业使命追求的是AGI,与此同时让它变得accessible

and beneficial to all human

beings(有利于人们且普慧。因此我们都觉得我们会继续去干更多的实体模型,追寻模型水平与此同时与应用做更好的对接。当然我们自己是个

believe in scaling

law(坚信经营规模基本定律)的,因此我们在实体模型变得更大,或者我们用更多的云计算服务器时,我们自己的实体模型智能化会逐步提高。

李开复:我补充一点,关键是相关超大型模型数据有的公司做小模型。我们的计划是以最少到最大模型都希望能够保证国内最好,因此我们刚才说了在6B、9B、34B,以后可能有较小的实体模型公布,它们是一样规格做到业内最好,我不敢说第一,但是总体来说是第一梯队或是是最佳的一两名这种表现,并且在各个方面,在编码层面、汉语层面、英语方面的表现都是很好。

我们坚信如同一周前我讲的TC-PMF,永远是一个翘翘板,你要平衡你应该多高的技术性,那么你付不付得起这个技术所需的成本费。业内有多种不同的运用,从最简单的在线客服运用,到手机游戏,一直到特别难的逻辑推理对策、科学新发现等难度系数,我坚信大尺寸

scaling law,最牛地面往 AGI

走实体模型,在最难的问题上,大家就愿意花钱的领域中,绝对是有落地场景,并且是最有可能做到AGI。

同时我们也真诚,有各种各样的较小的简易运用的机遇。大家的玩法是一个都不放过,大家在每一个潜在性存有尺寸上公布我们能做到特性最大,并且逻辑推理性价比最高,这一逻辑推理成本费还会带来更多的经济发展价格跟标价给开发人员应用。

黄文灏:有关benchmark再补充一点,每一个企业建自已的实测管理体系,大家内部也建自己的实测管理体系,大家去LMSYS以前在自己实测集在实测过全部实体模型,那时候我们大概分辨我们自己的实体模型水平确实做到世界一流,中国第一这样的水平。我们自己实测集和LMSYS最终的结局高度吻合。而且我们的实测集全是真实情景所得到的一些数据,还是比较公平公正的。

而且我们在我的产品中运用我们自己的实体模型以后,这些产品的用户数据都有很好的一个提高,其实也可以当作实体模型水平的金标准。

Q:零一自然万物GPU有可能是谷歌搜索、微软的5%,但算率模型拟合发展趋势限制是客观存在的。当榜上排名前列

OpenAI、Google能力早已提上去,网络资源还靠前情况下,零一天地万物该如何应对?

李开复:这是一个动态问题,我觉得现在来静止的看这个榜单说我还落伍那几个,因此它们一定是非常大的算率制作出来的。

这个其实更精确的应当从历史记录来说,看在过去一两年她们提高了是多少,大家提高了是多少,我们是否追的十分很近了,这是一个真理的客观性。

所以我不觉得他的算率更高则表示大家肯定没机会,自然他的算率更高有巨大的优势,但我觉得真理的客观性就是我们能够将相同的一张GPU挤压更多的价值来,这也是现在我们可以达到这些成果的一个重要原因。

另外是优化分析的performance主要表现,它不只是一个单纯科技与算法难题,里面含有数据库的配制,也有如何去优化,与此同时优化训练和influence,还有我们的实体模型如何加入跨模态等等一系列方面的技术,我觉得大家实际上在这一方面是不输给国外。

我刚提到Google的一个VP,他感觉我们都是令人惊奇的做到这样一个成效,所以我认为我是不会觉得算率远远地落伍。大家算率一直远落伍,大家一年前算率都是仅有Google、OpenAI的5%,目前还是,大家如果使用5%的算率能够将落伍迅速增进,未来我们或是希望有令人惊讶的结论。

能不能达到第一,能否超出,自然就是一个艰难的任务,可是我们都是向着这一目标在不断,我认为今日的结论比照一周前,比照上年11月,比照大家创立时,都是一个令人惊奇的飞越,因此看待事物需看这件事情要在增涨还是下跌,而并不是你今天还是落伍,因而之后就会落伍。

Q:大模型试炼场真实用户的实际 prompt ,是否对实体模型实测的专业度比不上更专业的实测集?

黄文灏:分两方面说。一个就是这个实测更贴近客户的真实情景,因此实体模型这些能力被消费者更应该。另一方面,LMSYS也考虑到这一部分,由于也有许多客户用很难的问题有意,也不是有意,就是真的测试模型智能水平,因此他们也做了hard

prompt的section,刚刚开复介绍的时候说成最烧脑的那一个排行榜,就会发现大家模型在那一个榜单上的排行更高一些,只要我们实体模型智能水准在这一方面有比较好的反映。

我补充一点hard

prompts,你如果上升LMSYS官方网站,而且也是在前两天发布,尤其针对用户深层次难题里选择尤其complex繁杂,尤其demanding,模型拟合智能水平要求比较高,更rigorous,这需要能力更多元性,并且更加强大,因此他们都在客户的实际键入里尤其单杀了一些尤其困难的艰辛引导词新算出来成绩。

自然不同类型的实测集有着不同的着重点,可是是从客户真实情景、真正提出问题里挑出来的艰辛引导词的评分。

Q:您之前提条件太大实体模型市场发展不能走ofo砸钱烧钱玩法,但事实证明目前国内的确打着大模型价格竞争,在这过程中零一天地万物和其它新成立公司怎样在激烈的市场竞争中超越大型厂?

李开复:今日大家可以看到的减价我们关注到这个现象,我们自己的标价或是非常合理,并且我们也在花较大时间精力希望可以使它再降下去,我认为一定程度整个市场每一年减少10倍逻辑推理成本可以期待的,并且必定也应当所发生的。今日很有可能处在一个相对较低的点,但我觉得假如说之后大概以一年减价10倍来说,这也是一个好消息,对整个行业全是喜讯,因为今天的API实体模型启用还是一个十分极低的占比,假如一年减少10倍那诸多的人都可以用到,这是一个非常利好的消息。

大家也觉得我们现在可以看到的实体模型主要表现大家超出其他模型,欢迎大家不认可的同行来LMSYS打擂,证实我是不对的。可是直到那一天产生,我们会继续说我们是最好的实体模型。

对规定最高,要求最高,必须最好是模型,他们当然用我们。100万只token花十几块或是花几元有很大差别吗?100万token对非常大的运用,比较难的运用,我觉得大家是大势所趋首选,大家发布后获得世界各国很高的点评,不过我们是一个可以跨过中国和外国的API,对于中国和外国都对外开放,我们有信心在全球范围内范围是一个表现很好性价比高也很合理的一个实体模型。

好,这样的话讲完了,我知道你的意思是说中国常看到ofo式狂热的减价,两败俱伤的玩法。我认为大模型制作公司不会那么不理性,因为技术还是最关键的,假如是技术不好,就单纯靠垫钱亏本去做买卖,大家绝不会跟这样的一个标价做对比,大家对自身的实体模型表现就是非常自豪的。

就好比你假如有一台特斯拉汽车,它也不会因为其他品牌车子比它售卖的非常便宜他就认为它要减价,我们都是特斯拉汽车,我们自己的价格是适宜划算的。

假如你又问也许以后我国就是如此卷,大伙儿宁愿亏光通输都不让你赢,那么我们就走其他国家销售市场。

Q:比照国外第一梯队,中国自落伍到做小差别,为何做为后来者的千亿元参数模型在scaling

law上看上去能够加速的?确定Yi-Large性能增加加快的核心因素也有哪一些?在算率还远远不够多前提下让Yi-X-Large做到GPT4的水准,下一步要解决的最主要的技术性需求是什么?这种情况提供给模型推理责任人文灏。

黄文灏:最先我觉得大家一开始落伍并没有7-10年没有多少,很有可能以前落伍一段时间,但是现在比较接近了。

最先干的事是,零一天地万物每一步在模型推理里的管理决策都是正确的,这个看起来是比较容易的事儿,但是做下去是比较难的。

包含我们一开始花了很长时间去干数据信息品质提高,大家去干scaling

Law,并没有很急的发布第一款实体模型,将我们的基本做的比较好,下面我们不断地提升数据质量,不停的在做scale

up,大家在基本体系建设完之后,在scale up的时会非常顺畅。

另一方面就是我们非常重视infra的建立,便是优化算法 Infra 其实是一个 co-design

的一个过程,在这样的情况下我们才能够将我们的算率发挥到极致好一点的水准。

所以我认为只要我们前边写对了很多事情,follow这一途径下来我们跟世界一流人才梯队之间的差别是会越来越小的。不过我们在这过程中建立了一个比较强的人才队伍,大家拥有自己培育的,也有被我们自己的使命和愿景吸引住过来的人,大家一块去做这个事情。所有人都是工程、Infra、优化算法三位一体,这些人才在未来还会充分发挥非常大的功效。

Q:在Coding层面刚刚开复教师提及了Yi-Large并没对于Coding做专业提升,但是位列第二。专业做优化的则排行好像并没有见到上去,这是什么原因?在Coding上的优势是如何达到的?大家提供给文灏。

黄文灏:刚刚提及没有专门对Coding做优化,是因为他们在LMSYS上边模型与在大家自己的品牌之中的模型API是完全一致的。大家也讨论过客户需求,Coding并不是大家十分常用的情景,大家可能会在实际场景中有一些Coding难题,但到非常丰富的Coding原因还是用到一些Coding专业模型,所以我们会有一个general模型,只要我们感觉LMSYS是更加general一些,公司提供是一个general模型实测。惊讶的是发觉他在Coding上也做的还挺好。

第二,大家有一些做Coding重点的改善,我们都觉得Coding都是大模型发挥才能的一个场景,我们也许将来也会有一些相对应方案在这里,因此我们做了Coding专业实体模型,Coding专业实体模型会让Coding情景,例如编码改变、长编码继写、代码补全有很好的整体性能。以后我们也会陆续把Coding重点实体模型对外开放出去。

Q:现阶段AI的练习是不是碰到数据信息荒的状况?平时用国内弱智吧算法训练开源系统版本Yi-34B成效显著,零一天地万物会不会独辟蹊径的练习数据库?现阶段好一点的数据信息来源是哪里啊?其实我们可以回答的尺度就能。

黄文灏:首先我们要并没有遇到数据信息荒的难题,最少我们可以看到数据信息也有一两个数量级的提高,数据信息还是有一些可以挖掘的一些发展潜力,这里还有很多正在进行中工作中,实际很不方便表露如何做,可是我们的确见到数据信息有非常大的发展潜力。并且我们最近在跨模态上有一些finding,能够更进一步提升一到两个量级的数据量。

弱智吧我们能简易交流一下,这一工作就是我们这边的intern和一些科研院所签约合作。当时也是我们的想法,这些信息能够对模型推理有一些帮助,其实做数据团队一直有这样的脑洞去开拓不同类型的数据信息情景,提升数据信息质量以及数据库的diversity。

李开复:总算说出来,弱智吧就是我们的点子。

Q:GPT-4O开始做起原生态跨模态实体模型,统一文字、声频、图象、视频内容输出的跨模态大模型会是一个确定方向吗?能否透露一下零一天地万物在跨模态的推进。

李开复:其实和大家沟通交流完的媒体朋友与外界人会了解,大家去年一直都觉得全模态分析实体模型,omni,也就是大家挑选了一样的词汇早已正在做这份工作,这份工作并不是别人出去再盲目跟风可以跟上的,大家有一定的累计,我们也相信全模态分析是前进方向。从我们的release

schedule 而言,我们只能说于今年大家可以期待一个惊喜,小细节请文灏再补充。

黄文灏:对。我们一直有正在做跨模态,原生态跨模态实体模型,也有一些进度,但它里面会有一些便是dependency,也就是说我们需要一个极强的

language model ,或者一个 language model 锻炼的方式。随后下面你可能会 scale

up跨模态实体模型。我们其实在小一点size上有一个基本上和gpt4o作用一样的,便是 any to any

的跨模态实体模型,随后剩下来的有可能是scale up 的一些工作

有关这个是不是可预测性方位?这是一个对外开放难题,大家一定要通过实验的finding来确定这个是不是一个可预测性方位。由于我们的使命要提升智能化限制,跨模态认知和形成这俩每日任务是否都是在提升智能化上限。第二个是跨模态实体模型对比文字实体模型能否提升智能化上限。

我简单说一下大家在一些方向中见到一些比较promising的早期实验结论,我们都是相信这些能提高智能化限制。

Q:零一自然万物API价钱是否会降低?

李开复:现在没调节消息和大家分享,我们目前接到反馈还是相当正向的,并且几个开发人员一看到,很快就更换其他实体模型。我觉得实体模型需看它的表现,或许有些行业,比如说一些难以取回钱行业要对比价格,总之有足够多的在挑选大家,大家刚出来,有那么多忠实爱好者加入,我们首先服务周到她们,价格再说。

到今天为止,刚公布性能一定是中国性价比比较高。可能很多人有效千token、上百万token,大家可以自己计算一下。

Q:零一天地万物在产品创新层面将来有没有一些整体规划。

李开复:有,大家上星期发布的产品基本上是我们的方向,我认为一方面大家已经推出了一些非常成功的国外商品,是可以算得上万知的父亲,早已在国外获得特别好取得成功,在今年的预估会出现大约1个亿的收益,不过不是砸钱方式烧出来的。

不过我们此外也有几个同类产品在国内外在检测中,自然万知大家也将继续勤奋将它越来越好,特别是在对于PPT的功效获得十分正脸反馈,因为这是一个跟国内其他大模型很大的差异点,这个是我们应对顾客consumer商品的介绍。

大家也有自己走一个公司级模型方位,但现在基本客户在海外,对于我们来说海外客户的付费意愿或是付钱额度比国内大的多,因此虽然我们在我国也十分期待服务项目国内用户但是按照现在TO

B卷状况,几十万做POC,上百万做一单,大家做一单赔一单生意,大家初期在AI1.0时期太多,投得多,大家坚决不做。